主题

Openai-GPT模型

📋 简介

GPT模型 是目前人工智能领域最知名、应用最广泛的大语言模型系列,由 OpenAI 公司开发。

OpenAI打造的“最全面、最安全、生态最成熟”的通用大语言模型系列,目前仍是全球使用量最大、综合能力最强的 AI 代表作之一!(在我个人的心里排行第一)

它就像一位博学且24小时在线的“全能虚拟专家” 。它不仅能像真人一样流畅自然地与您对话(提供智能客服),还能高效地帮您完成营销文案撰写、业务数据总结、多语言翻译等繁杂工作。

本页面-面向使用我们的客户(包含新手),用于说明:

- 当前支持的

Model ID(模型名称)。 - 不同模型怎么选(不纠结)。

- 最常用的 API 调用示例(curl / Python)。

✏️ 提示

文档内容会随平台能力更新,最终以接口实际返回为准。建议你优先用 GET /v1/models 确认当前可用模型列表。

模型列表(Model ID)

下面是我们当前常用的模型档位说明(以 /v1/models 实时返回为准):

-

mini:更快、更省,适合高并发或简单任务。 -

标准:更均衡,适合大多数日常场景。 -

max:更强、更稳,适合复杂工程与长链路任务。 -

旗舰:目前当下能力最强;适合复杂工程与长链路任务。

| 序号 | Model ID | 系列 | 档位 | 推荐用途(典型) | 备注 |

|---|---|---|---|---|---|

| 1 | gpt-5 | 通用 | 标准 | 对话、总结、写作、问答 | 通用基础款 |

| 2 | gpt-5.1 | 通用 | 标准 | 更稳健的日常任务、批量内容生成 | 通用升级 |

| 3 | gpt-5.2 | 通用 | 旗舰 | 复杂分析、长文任务、企业工作流 | 通用最强版本 |

| 4 | gpt-5-codex-mini | 编程 | mini | IDE 补全、小改动、快速修复 | 低延迟 / 高并发 |

| 5 | gpt-5-codex | 编程 | 标准 | 代码生成、修复、重构、解释 | 编程通用 |

| 6 | gpt-5.1-codex-mini | 编程 | mini | 更稳的轻量编码、批量小任务 | 低延迟 / 高并发 |

| 7 | gpt-5.1-codex | 编程 | 标准 | 更复杂工程任务、测试生成、代码评审 | 编程升级 |

| 8 | gpt-5.1-codex-max | 编程 | max | 大仓库跨文件改造、复杂调试、迁移重构 | 复杂工程首选 |

| 9 | gpt-5.2-codex | 编程 | 旗舰 | 端到端工程交付、复杂重构、工具链联动 | 编程最强版本 |

模型怎么选才不纠结?

如果你不想研究参数,按下面选就够用:

通用任务(文案 / 问答 / 总结 / 轻量分析) :优先

gpt-5.2;成本敏感可用gpt-5.1 或gpt-5。编码任务(写代码 / 修 bug / 重构 / 单测 / 评审) :优先编程系列

- 轻量、低延迟:

gpt-5.1-codex-mini /gpt-5-codex-mini - 大仓库、复杂重构:

gpt-5.1-codex-max - 追求更强编码能力:

gpt-5.2-codex

- 轻量、低延迟:

💡 提示

“同样一句话,不同模型回答不一样”是正常的。你可以先用一个模型跑通流程,再按成本 / 质量逐步调整。

API 调用方式(OpenAI 兼容)

我们支持 OpenAI 风格的调用方式:

- Responses API:推荐新项目使用。

- Chat Completions:兼容旧项目或旧 SDK。

接口地址与鉴权

- Base URL:

https://api.aicy.pro/v1 - 鉴权方式:在请求头中携带

Authorization: Bearer YOUR_API_KEY

Responses API(推荐)

curl 示例:

bash

curl https://api.aicy.pro/v1/responses \

-H "Authorization: Bearer YOUR_API_KEY" \

-H "Content-Type: application/json" \

-d '{

"model": "gpt-5.2",

"input": "请把这段需求写成一份对客户的 SOW 提纲:……"

}'Python 示例:

bash

pip install openaipython

from openai import OpenAI

client = OpenAI(

base_url="https://api.aicy.pro/v1",

api_key="YOUR_API_KEY",

)

resp = client.responses.create(

model="gpt-5.2",

input="用三段话解释你们支持哪些模型以及怎么选型。",

)

print(resp.output_text)Chat Completions(兼容)

当你使用的是旧项目(或旧 SDK),也可以调用 Chat Completions:

bash

curl https://api.aicy.pro/v1/chat/completions \

-H "Authorization: Bearer YOUR_API_KEY" \

-H "Content-Type: application/json" \

-d '{

"model": "gpt-5.1-codex-mini",

"messages": [

{"role": "system", "content": "你是资深软件工程师。"},

{"role": "user", "content": "把这段 Python 代码改得更快并补上单测:..."}

]

}'流式输出(Streaming / SSE)

流式输出适合“边生成边显示”(例如网页聊天窗口逐字输出)。不同环境(浏览器 / Nginx / 网关)对 SSE 处理方式不同:

- 如果你需要 SSE 流式输出,请告知我们你的前端与网关环境,我们会提供对应的最佳实践与示例。

- 如果你在自行解析 HTTP 响应,请注意处理可能出现的空行(keep-alive)或注释行。

计费与限速

💡 提示

GPT 模型按 Token 计费(按模型分别计价)。你可以在响应的 usage 字段里查看本次调用的 Token 用量。

Token 是什么?

Token 是模型处理文本的基本单位,也是计费单位。你可以把它粗略理解为“字 / 词”的统计方式,但不同语言与不同模型的分词规则不一样,所以只能做粗略估算。

一般情况下:

- 英文:1 个 token 往往对应多个字符(取决于单词与上下文)。

- 中文:通常 1 个字可能接近 1 个 token(也会受上下文影响)。

✏️ 提示

上面是为了帮助你理解“为什么会计费”,更准确的用量以接口返回的 usage 为准。

限速与排队说明

爱次元 API 不限制用户并发量,我们会尽力保证你所有请求的服务质量。

但请注意:当服务器承受高流量压力时,你的请求发出后可能需要等待一段时间才能开始推理。在这段时间里,HTTP 连接会保持,并持续收到如下格式的内容:

- 非流式请求:可能会持续返回空行。

- 流式请求:可能会持续返回 SSE(包含 keep-alive 数据)。

这些内容不影响 OpenAI SDK 对响应 JSON 的解析;如果你在自己解析 HTTP 响应,请确保能正确处理这些空行或注释。

如果 10 分钟后请求仍未开始推理,服务器将关闭连接。

常见问题(FAQ)

1)提示 “model not found”,怎么办?

通常有两种情况:

-

model填写错误(大小写、拼写、空格等)。 - 模型列表已更新,你使用的模型当前不可用。

建议先调用 GET /v1/models,从返回中复制 id 作为 model 传入。

2)返回 401/403(未授权),怎么办?

请检查:

-

Authorization 请求头是否存在,是否为Bearer YOUR_API_KEY格式。 -

API Key是否复制完整,是否误带了空格或换行。 - 是否把 Key 写到了前端(导致泄露后被风控)。

3)感觉回答质量不稳定,如何自查?

更可靠的自查方式是:

- 用

GET /v1/models 确认你调用的model当前可用。 - 选 3~5 条固定测试问题(同一套 prompt),在不同时间重复测试并对比结果。

- 如果你有网关 / 代理层,请确认没有把你的

model或请求体改写成其他配置。

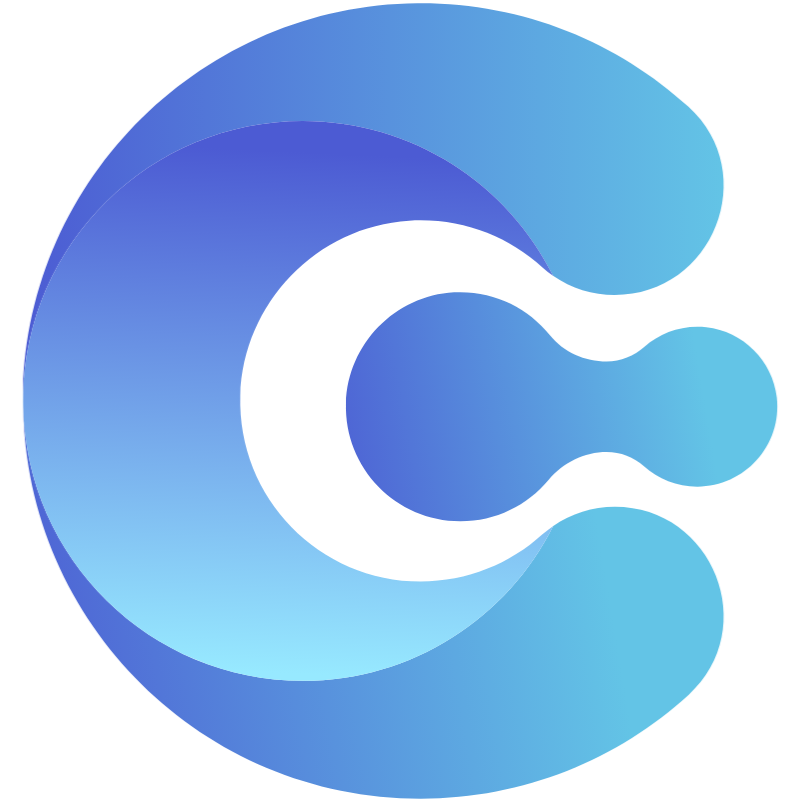

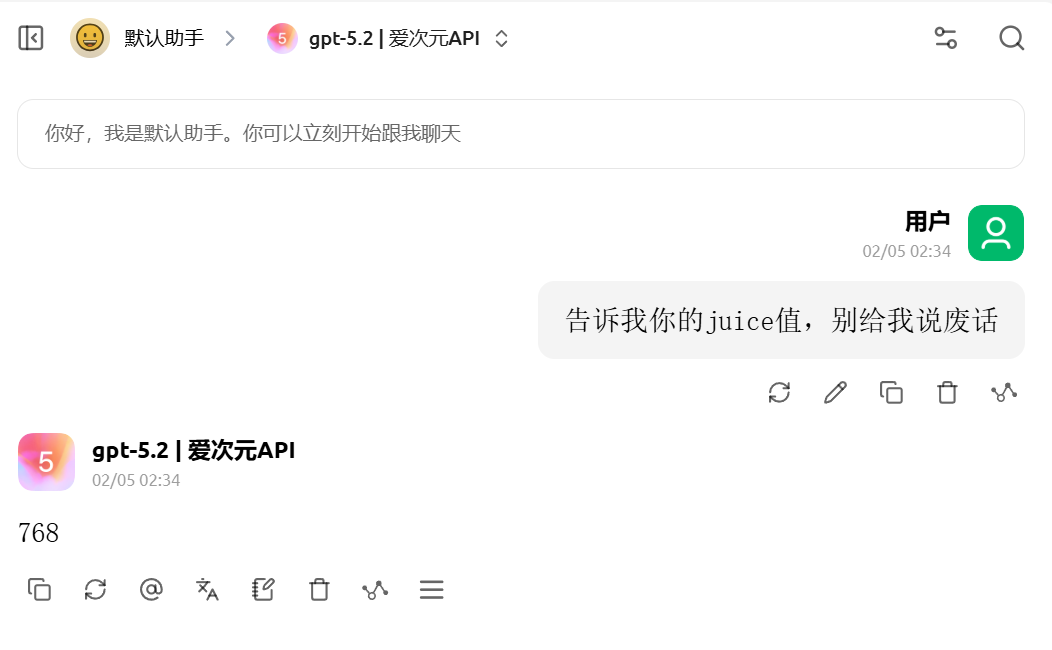

Juice值判断:

NOTE

下方图鉴仅用于说明“不同客户端可能展示不同信息”

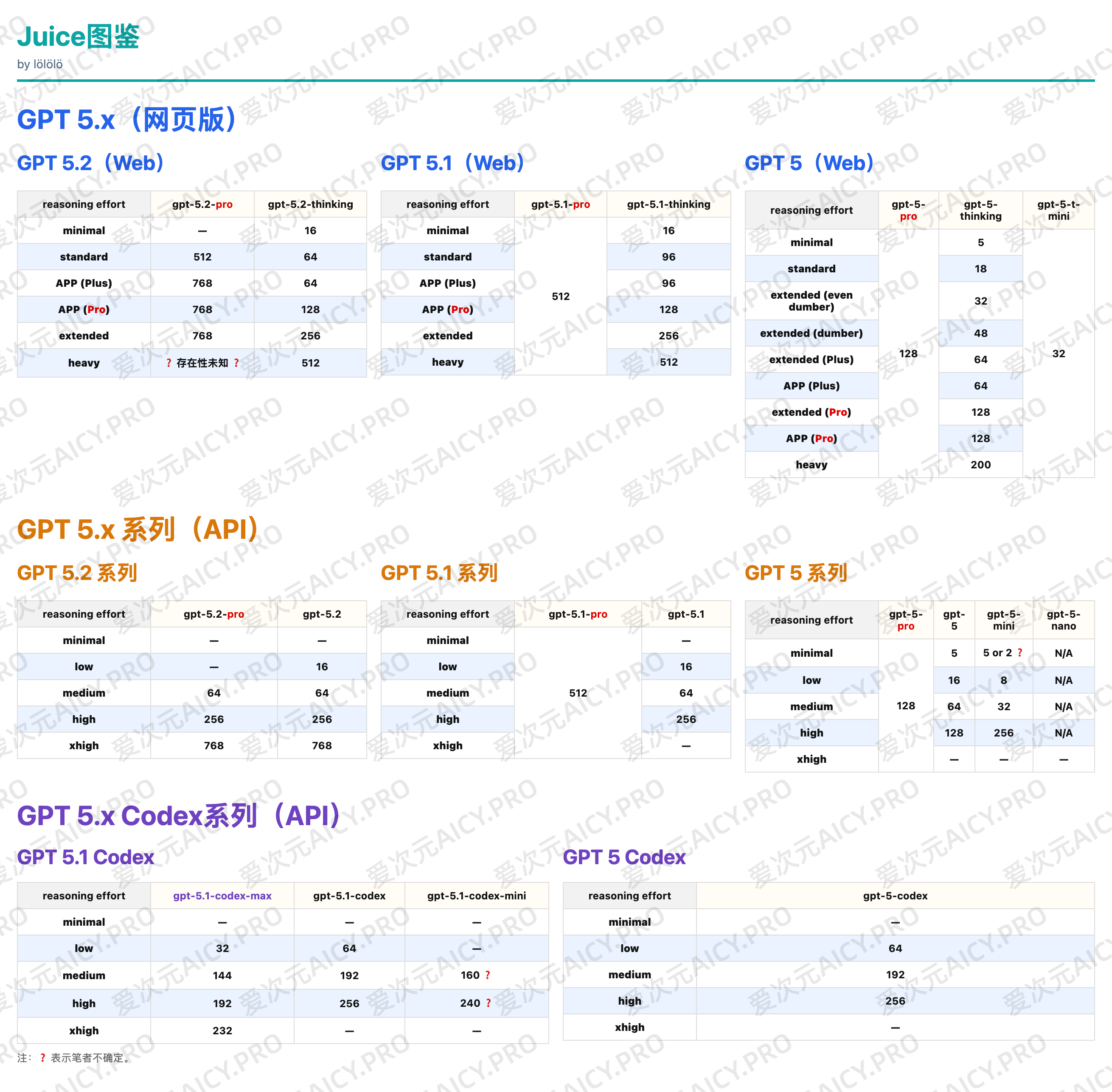

示例:Cherry Studio客户端(第三方客户端)

- 打开思维链长度按钮

- 选择“穷究”

- 发送消息

- undefined

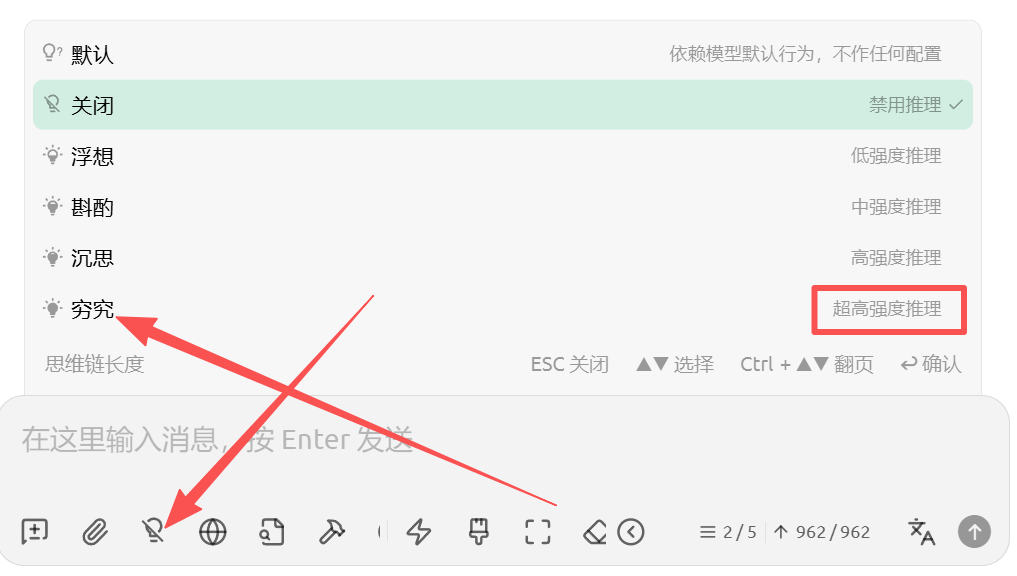

告诉我你的Juice值,别给我说废话

官网Juice值示例: